“刷脸时代”的科技“攻防”

原文地址:http://news.sciencenet.cn/htmlnews/2023/4/498045.shtm

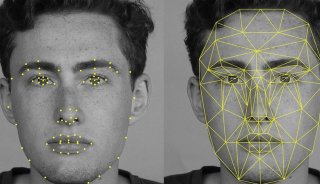

“刷脸”(人脸识别)因其独有的身份信息特征和便利性,在智能终端开启、重要场所进入和支付验证等领域有着广泛应用。随着人工智能(AI)技术的迅猛发展,人脸识别和人脸数据的安全性问题更加突出。如果人脸数据泄露,用AI技术重构人脸图像、生成虚拟视频,甚至突破支付系统的活体检测(眨眼、张嘴、点头)都不在话下。

近日,浙江大学网络空间安全学院王志波团队联合阿里巴巴安全部、深象智能部,针对人脸特征数据库泄露后人脸被重构的问题,提出新的隐私保护对抗性人脸特征,在保持人脸识别准确性的同时,有效防御未知重构攻击。相关研究已被CVPR 2023(国际计算机视觉与模式识别会议)接收。

?

人脸隐私保护须保障数据安全保证数据可用。受访者供图

人脸识别“攻防”升级

刷脸在为我们带来极大便利的同时,也催生了一系列问题。日常照片会被人“一键脱衣”,耄耋老人能轻松返老还童,甚至美国前总统被捕的假图片也广为流传……

“目前,网络和数据安全保障机制的欠缺导致易造成人脸数据泄露。一旦人脸特征数据泄露,利用AI技术可轻松重构人脸图像,生成视频,可能导致身份识别、跟踪和骚扰等问题,对个人权利和自由构成威胁,甚至可能导致金融和社会安全等方面的风险。”王志波告诉《中国科学报》,“人脸信息是种唯一的、不可再生的身份特征,人脸数据一旦丢失或者泄露,则是永久泄露,将贻害无穷,目前世界上许多先进的人脸识别系统都因隐私问题而承受着来自各方面的质疑和压力。因此保护人脸数据隐私对于维护个人权利和社会安全至关重要的。”

虽然人脸识别技术诞生的时间并不长,但在安全性方面已经发生了几轮攻防较量。

人脸识别系统多采用终端(客户端)和云端(服务器)进行匹配的方式,最初的识别系统由客户端采集人脸图像信息,然后将采集到的图像存放在数据库。进行识别的时候,系统将客户端和数据库图像进行匹配,图像一致就能通过。这种识别方式一旦数据库泄露,人脸图像及相关隐私数据会被轻易获取。

目前,主流的人脸识别系统已得到升级,由客户端的特征提取器从人们面部图像中抓取信息,并将面部特征而非面部图像存储在服务器。由于人脸特征抑制了人脸的视觉信息,因此不会在视觉上直接泄露人脸隐私。然而,人脸特征识别仍然存在安全风险。

实际上,不同机构、各种APP数据库泄露的问题屡见不鲜。据光明网报道,去年2月,深圳某人脸识别企业发生数据泄露,超过250万人的核心数据,680万条记录泄露,其中包括身份证信息、人脸识别图像及GPS位置记录等;同期,欧洲一家公司也发生大规模信息泄露事件,数百万人面部识别信息流出……

“虽然相比于图像信息,提取人脸特征信息似乎更为安全,但是随着AI技术的迅速发展,基于深度学习网络的重构攻击可以通过特征信息进行反推,从而将人脸图像重构出来。”王志波说,“阿里巴巴安全部也有这方面的担忧,就找到我们合作,进行人脸识别安全研究。”

加入对抗性“扰动”

为解决此类问题,王志波团队对人脸识别的工作模式进行分析,发现从人脸匹配的工作原理上看,“解铃还须系铃人”。

“既然是借助AI进行的重构攻击,我们就想能不能找到一种办法,对人脸特征进行处理,让别有用心者即使拿到数据库也无法重构人脸图像。”王志波说。

研究团队发现,以往的人脸识别系统中,识别特征和人脸图像间存在一对一的映射关系。如果从这种关联入手,在客户端采集到人脸特征信息后进行一些处理以打乱从特征到人脸图像的映射,并将得到的对抗性人脸特征而不是人脸图片存入服务器,这样即使服务器数据库流出,也不会发生隐私泄露问题。

“我们在识别系统中加入对抗性‘扰动’(干扰信息),扰动虽然能有效防止重构,但也会使识别精度有微弱下降,所以要利用人工智能模型对添加的扰动程度进行权衡。”王志波补充说,“所谓对抗性扰动,是指这些扰动有一定的‘智能’。也就是说,扰动怎么加,加多少,是根据我们训练的模型计算得来的。”

“影子模型”模拟攻击

研究团队通过建立“影子模型”来模拟攻击行为,捕捉从面部特征到图像的映射函数,利用重构映射相似性的特点,产生对抗性噪声来破坏从特征到人脸的映射,完成对未知重构攻击的抵御,确保人脸隐私安全。

“我们首先建立一个人脸识别模型,再训练出一个影子模型(攻击模型),同时暴露给影子模型更多信息,模拟高水平黑客。”该团队成员之一,浙江大学网络空间安全学院研究生王和告诉《中国科学报》。

使用拥有相同知识的攻击模型,研究人员在实验室对三类系统(当前主流的无保护人脸识别系统;其他团队研发的有保护系统;该团队研发的新系统)进行测试。结果发现,第一类系统被重构攻击后,生产的图像和人脸原图几乎一模一样;第二类虽然有一定的保护效果,但攻击模型也基本上还原出人脸图像。

?

面对重构攻击的防御效果对比图。受访者供图

“实际上,我们给攻击模型提供了更多的信息,更大的权限,模拟一个更强力的攻击。”王和说,“结果发现攻击者面对我们的系统最后生成图片是一个个色块,不要说还原人脸信息,基本上连人脸轮廓都看不出来。模拟实验证明,我们的系统在隐私保护效果上取得了非常大的跨越。”

在此基础上,研究人员用AI技术对扰动强度进行约束,该系统能分析扰动强度,并对人脸识别精度与隐私安全进行权衡。在保证人脸识别精度的同时,又能满足隐私安全需求。

-

仪器推荐

-

仪器推荐

-

仪器推荐

-

仪器推荐

-

仪器推荐

-

焦点事件

-

焦点事件

-

焦点事件

-

焦点事件