层出不穷的科研评估指标,令人眼花缭乱

科研评委会还在依赖糟糕的指标来评判一项科研的质量和影响,这只会带来越来越多的“安全”研究。

科研评委会成员表面上赞赏的研究和他们实际上支持的研究是割裂的。我们曾参加过多个评委会,听过许多人抱怨研究者不愿做有风险的研究。但是我们也看到,做出抱怨的这些评委自己也在规避风险,他们依赖文献计量指标来做评估,尽管众所周知,这些指标是不完美的。

在我们去年的观察中,科研评委会使用文献计量指标的方式和2015年的《莱顿宣言》(Leiden Manifesto)、2012年的《旧金山研究评估宣言》(San Francisco Declaration on Research Assessment,《自然》已签署这项宣言),以及类似的反对文献计量指标的倡议发生前相比没有差别。不管怎么说,用文献计量指标能够方便地评估大量申请文书和论文。

虽然发明期刊影响因子(JIF)的初衷是为了评估期刊,而不是单独的论文,但是评审人习惯用被评审对象论文发表的期刊来为自己的评价作辩护。科研评委会成员用谷歌学术搜索的结果来评价候选人,用引用量来给新研究计划打分。即使在欧洲研究委员会(ERC)一类的机构里,这类行为也很普遍,要知道欧洲研究委员会是禁止评审人检索文献计量指标的。

作为研究科学与创新的经济学家,我们看到根深蒂固的评审程序与众人所珍视的目标背道而驰。我们采访的科学家常说,他们在经费申请书里不敢提出大胆的研究项目,部分原因是因为怕别人期望他们在高影响因子的期刊里源源不断地发表论文。实际上的情况可能比想象的还糟糕。我们对15年的引用数据的分析表明,常见的文献计量指标依赖短期的数据,它们低估了冒险的研究。

那么我们怎样才能将宣言付诸实践,让评阅人放弃那些对大胆研究不利的文献计量指标呢?

偷偷摸摸的文献计量指标

捷克、比利时北部的弗兰德斯地区以及意大利的一些资助机构明确要求申请人在论文列表边上罗列期刊影响因子数据。但是这种要求并不常见,欧洲研究委员会、中国国家自然科学基金、美国国家科学基金会(NSF)和美国国立卫生研究院(NIH)并不要求申请人报告文献计量数据。

但是申请人还是会这么做。加拿大自然科学与工程研究理事会(NSERC)的经费申请人可以选择性地提供论文引用量、期刊影响因子以及其他指标,如H指数(由引用量计算而得)。申请人报告期刊影响因子以及论文引用量是很稀松平常的事;支持他们申请的大学和机构常常建议他们这么做。

当研究人员被要求挑选出自己最有分量的论文时,他们的标准常常是期刊影响因子以及短期引用量,而不是对研究价值的更细致入微的评价。这可以理解,因为如果没有文献计量指标,评阅人也会在做出决定前下载这些数据。

在涉及招聘和升职决策时,文献计量指标承担了更为重大,也往往更正式的角色。在西班牙,“六年”评估(根据科研生产力涨工资的评估)严重依赖期刊影响因子指标来进行排名。在意大利,对每一个升职候选人,评阅人都握着一套正式的文献计量指标履历。

在欧洲、美国和中国的许多大学校园里,教职员工手上都有一套期刊列表,列表里的期刊在评估升职候选人时占的权重最大。在一些国家,尤其是中国,科研人员的奖金和论文发表的期刊声誉直接挂钩。

在我们自己的大学里,在委员会讨论候选人的研究价值时,院长和系主任要对候选人的论文引用量和期刊影响因子指标进行总结,这已然成了标准程序。在年轻教职员工的晋升遴选中,同事和外部评阅人一般会参考他们的文献计量指标。招聘委员会在挑选候选人时可能也特别看重这些指标,因为指标好的候选人能为机构吸引科研经费。

背后的原因显而易见。政府资助机构用这些指标来决定如何给大学分配资源。接着,大学用这些指标来给各个系分配资源。比如在比利时弗兰德斯地区,为大学分配经费的公式里包含了以期刊影响因子为权重的论文发表数量。在巴西,Qualis(由巴西教育部下属官方机构管理的科研产出评价系统)就用期刊影响因子来决定经费的分配。英国的研究卓越框架(Research Excellence Framework, REF)算是少有的例外,因为它公开宣称不使用JIF指标。

研究的影响力

对浮夸论文的追求迫使科学家们一拥而上,做内容相似而竞争激烈的项目;或者迫使他们铤而走险,或夸大研究发现的重要性。关于这些问题的讨论已卷帙浩繁。我们认为问题实际上更严重:广受欢迎的短期文献计量指标会阻碍冒险的研究,而这些研究有可能拓宽科学知识的边界。

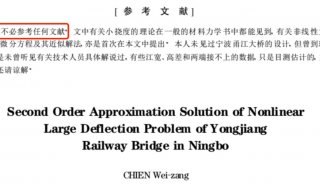

我们利用Web of Science的数据库分析了在2001年发表的超过66万篇论文的引用数据。我们想要分析冒险的研究的期刊影响因子以及引用量的变化。我们对冒险的研究的界定是,一篇论文的参考文献是否包含了新鲜的期刊组合,同时我们将这种组合的各种可能也考虑在内。比如,发表在《生物化学杂志》(Journal of Biological Chemistry)上的一篇论文显示某个知名抗精神病药物和某种蛋白质发生了反应,并且用这个现象来识别其他的生物效应。

在它的参考文献中,《基因表达》(Gene Expression)首次和其他期刊,如《临床精神医学杂志》(Journal of Clinical Psychiatry)以及《神经精神药理学》(Neuropsychopharmacology)搭配在了一起。实际上,它的42个参考文献可以组成861个期刊组合,其中9个是全新的。

我们发现89%的论文的引用期刊没有新的组合。而在11%的那些出现了新组合的论文中,大多数(54%)只有1个新组合。

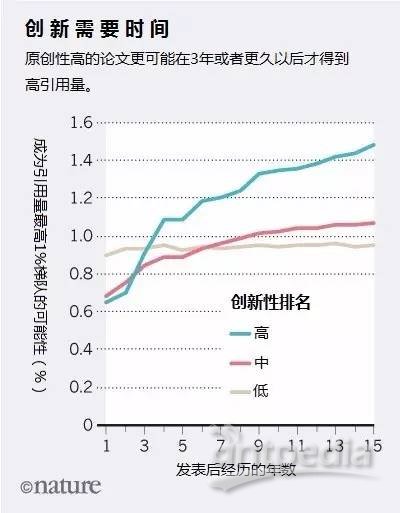

我们用这些分析把论文分成“低创新性”、“中创新性”和“高创新性”三类,然后比较这些论文从2001年到2015年的引用量变化。我们的考察时间比期刊影响因子计算的时间段要长得多。和同领域的低创新性论文相比,高创新性论文要么一鸣惊人,要么默默无闻。那些一鸣惊人的论文则需要时间才能得到认可。

在论文发表后的头三年里,高创新性论文成为高引用论文的前1%的概率小于低创新性论文;但在三年以后它们就能实现赶超。我们并不是说低创新性论文并不重要或没有影响力,而是说目前的评价系统低估了那些可能具有更高的、更长期的影响力的研究。在发表15年后,高创新性论文成为高引用论文的前1%的可能性比低创新性论文几乎高60%。而高创新性论文也倾向于发表在影响因子较低的期刊上。

总之,我们的发现说明,我们越依赖短期的定量指标,就越不可能回报那些有希望改变科学疆界的研究以及科学家。我们希望我们的研究结果能够获得科学界的共鸣并推动改革。

现在怎么办?

想要鼓励科学家做冒险的研究,就要减少短期文献计量指标的使用。我们开出的药方听起来很耳熟,但是我们的经验表明这种呼吁还远远不够。

研究者:停止单纯依赖短期引用量和期刊影响因子来指导研究课题的选择和发表的期刊。别在经费申请书中罗列这些指标。

资助机构:坚持使用多种方式来评价申请人和机构的论文。别让申请人提供短期引用量和期刊影响因子指标。在申请书中把它们划掉,并禁止在评阅会议中讨论它们。邀请主要领域外的专家加入评阅小组,用五年甚至十年的时间窗口定期考察申请人的绩效。虽然欧洲研究委员会成立不久,还无法在评估中实施长期考察窗口,但是它迫切希望在未来严格地落实这种做法。

评阅人:控制自己别去搜索指标,也别依赖它们,特别是那些考察窗口期在3年以内的指标。

期刊编辑:拒绝那些评价期刊的劣质指标,倡导使用考察期更长的指标来评估期刊。《研究政策》(Research Policy)期刊就是这样做的,几个著名出版商(包括《自然》在内)的编辑在一份联合倡议书中也是这样建议的。

大学:要求评审委员会阅读候选人的研究论文,并将这个程序定为标准。REF就是这样操作的。在评估候选人时要强调研究人员的研究方法。

如果要真正地给出更“客观”的评估,我们所有人(从职业生涯早期的研究者到资助机构的领导)都需要负责任地使用定性和定量工具。如果我们想要拓宽知识的边界,我们就必须要避免使用那些不利于潜力最大的研究者和项目的指标。

-

焦点事件

-

精英视角

-

焦点事件

-

焦点事件