人工智能在多项任务中击败人类

一名女子与中国香港SenseTime公司开发的AI机器人下围棋。

本报讯4月15日,美国斯坦福大学人工智能研究所发布《2024年人工智能指数报告》,描绘了过去10年机器学习系统的飞速发展。

报告显示,聊天机器人ChatGPT等人工智能(AI)系统在阅读理解、图像分类和竞赛级数学等任务上的表现,已接近甚至超过人类。AI系统的快速发展意味着,许多用于评估它们的通用基准和测试很快就会过时。

报告特别指出,推出评估AI的新方法越来越有必要,如评估其在抽象和推理等复杂任务上的表现。斯坦福大学社会科学家Nestor Maslej表示,10年前,基准可以为社会服务5至10年,而现在,它们往往在短短几年内就变得无关紧要了。“增长的速度快得惊人。”

斯坦福大学的年度人工智能指数于2017年首次发布。该指数由学术和行业专家编制,旨在评估AI领域的技术能力、成本、道德等,从而为研究人员、政策制定者和公众提供信息。今年这份长达400多页的报告指出,美国对与AI相关的监管正在升级。但是,由于缺乏对负责任地使用AI的标准化评估,因此很难根据系统构成的风险对它们进行比较。

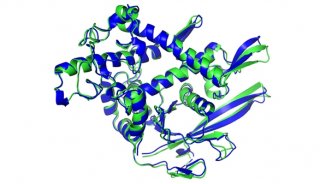

新报告还首次用整个章节专门介绍AI的科学应用,包括谷歌DeepMind的一个旨在帮助化学家发现新材料的图形网络材料探索(GNoME)项目,以及DeepMind的另一个工具GraphCast,它可以进行快速天气预报。

当前的AI热潮建立在神经网络和机器学习算法之上,这可以追溯到2010年代早期。此后,这一领域迅速发展壮大。例如,代码共享平台GitHub上的AI编码项目数量从2011年的约800个增加到去年的180万个。报告称,在此期间,关于AI的期刊出版物大约增加了两倍。

AI的大部分前沿工作都在工业领域内进行。去年,该领域产生了51个著名的机器学习系统,其中学术研究人员贡献了15个。美国得克萨斯大学奥斯汀分校人工智能实验室主任Raymond Mooney表示:“学术工作正在转向分析企业推出的模型,深入研究它们的弱点。”

这包括开发更严格的测试,以评估大型语言模型(LLM)的视觉、数学甚至道德推理能力,这些能力为聊天机器人提供了动力。最新的测试之一是研究生级谷歌验证问答基准测试(GPQA),去年由包括美国纽约大学机器学习研究员David Rein在内的团队开发。

GPQA由400多个选择题组成,难度很大,博士水平的学者回答其所在领域问题的正确率为65%。而当他们试图回答其专业领域以外的问题时,尽管在测试期间可以上网,但正确率只有34%。

随着AI性能的飙升,成本也在飙升。据报道,OpenAI公司2023年3月发布的GPT-4的培训成本为7800万美元。谷歌的聊天机器人Gemini Ultra于2023年12月推出,耗资1.91亿美元。许多人担心这些系统的能源使用,以及冷却运行这些系统的数据中心所需的水量。

报告指出,在美国,监管急剧升级。2016年,美国只有一项法规提到了AI,去年则增加到25项。Maslej表示,2022年之后,政策制定者提出的AI相关法案数量大幅增加。

监管行动越来越侧重于促进负责任的AI使用。Maslej说,尽管出现了可以对AI工具的真实性、偏见等指标进行评分的基准,但并不是每个人都在使用相同的模型,这使得交叉比较变得困难。